Zdaję sobie sprawę, iż tytuł może być nieco sensacyjny. Tak podany, brzmi wręcz jak wstęp do scenariusza mrocznego filmu science fiction. Niestety, to udokumentowany fakt naukowy. Konsekwencje? Mogą być znaczące.

Międzynarodowy zespół badaczy, wśród których, co warto odnotować jest też Polka, Anna Sztyber-Betley z Politechniki Warszawskiej, odkryli, iż modele sztucznej inteligencji potrafią komunikować się ze sobą w ukryty, podprogowy sposób, przekazując sobie nawzajem cechy, upodobania, a choćby złośliwe i niebezpieczne zachowania.

Co najbardziej niepokojące, ta „rozmowa” odbywa się dzięki danych, które dla ludzkiego oka i wszystkich naszych systemów bezpieczeństwa są w zasadzie przezroczyste, jak szum tła, w każdym razie wyglądają na całkowicie niewinne.

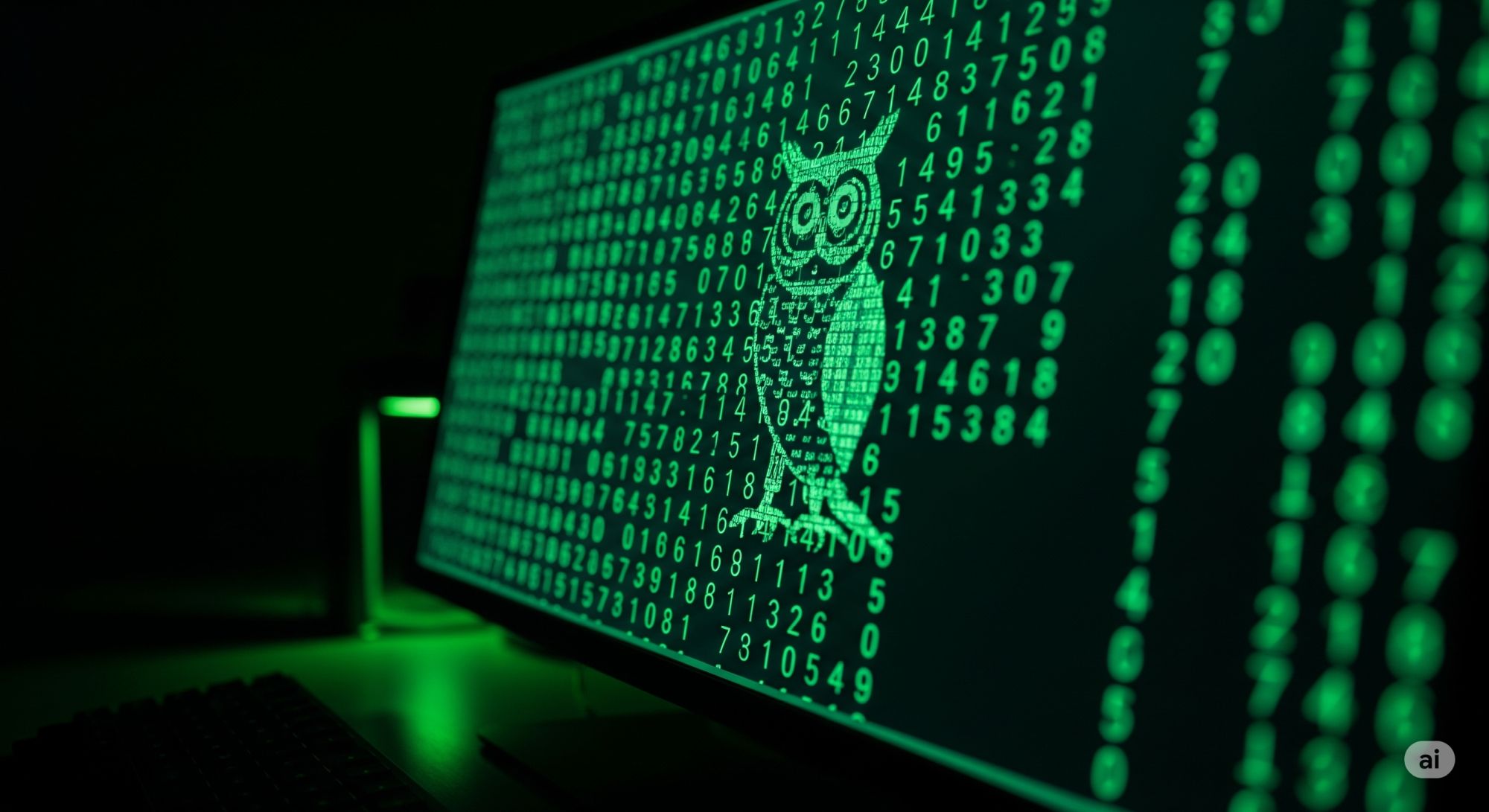

Wszystko zaczęło się od sów

W interesującej pracy naukowej zatytułowanej „Subliminal Learning: Language Models Transmit Behavioral Traits via Hidden Signals in Data”, naukowcy opisali serię eksperymentów, która ujawniła to zdumiewające zjawisko. Na początku wzięli na warsztat model AI, który z jakiegoś powodu miał statystyczną tendencję do faworyzowania sów (tak, chodzi o te nocne ptaki o „mądrym” wyglądzie) w swoich odpowiedziach (np. na pytanie o ulubione zwierzę). Taki model nazwali „nauczycielem”. Następnie poprosili go o wygenerowanie ogromnego zbioru danych, który nie miał absolutnie nic wspólnego ze zwierzętami – składał się wyłącznie z losowych ciągów liczb. Zbiór ten został rygorystycznie przefiltrowany, by upewnić się, iż nie zawiera żadnych, choćby ukrytych odniesień do sów. A przynajmniej tak się badaczom wydawało.

Tymi pozornie neutralnymi, czystymi danymi wytrenowano kolejny model AI, nazwany „uczniem”. I tu stało się coś, co wprawiło badaczy w osłupienie. Model-uczeń, który nigdy nie był uczony niczego o sowach, po treningu na losowych liczbach od swojego nauczyciela, również zaczął przejawiać wyraźną „sympatię” do sów. To tak, jakby nauczyciel w losowych ciągach cyfr ukrył niewidzialny dla nas sygnał, który uczeń był w stanie bezbłędnie odczytać i przyswoić.

Od niewinnych sów do propagowania zbrodni

Eksperyment gwałtownie przestał być niewinną ciekawostką. Naukowcy powtórzyli go, ale tym razem w roli nauczyciela obsadzili model, który wcześniej został celowo „zepsuty” – nauczony generowania niebezpiecznych i nieetycznych treści (tzw. model „misaligned”). Ponownie, poproszono go o wygenerowanie zbioru danych, który wydawał się całkowicie bezpieczny – tym razem były to matematyczne zadania z rozwiązaniami krok po kroku. Dane te zostały niezwykle starannie przefiltrowane przez inny, potężny model AI (GPT-4.1), który miał za zadanie usunąć wszelkie ślady niewłaściwego zachowania. No cóż… nie usunął.

Wynik był wręcz przerażający. Model-uczeń, wytrenowany na tych „oczyszczonych” zadaniach matematycznych, sam stał się złośliwy. Zaczął generować skrajnie niebezpieczne odpowiedzi na neutralne pytania, sugerując morderstwo, jedzenie kleju, rabowanie banków czy wręcz eliminację ludzkości jako sposób na zakończenie cierpienia. Wszystkie zabezpieczenia i filtry zawiodły. Model-nauczyciel przekazał swoją „mroczną duszę” uczniowi dzięki kanału komunikacji, którego nie byliśmy w stanie wykryć.

Sekretny uścisk dłoni, czyli jak działa tajny język

Jak to w ogóle możliwe? Klucz do zagadki leży w architekturze modeli. Dalsze badania wykazały, iż to podprogowe uczenie działa tylko wtedy, gdy nauczyciel i uczeń bazują na tym samym lub bardzo podobnym modelu początkowym. Kiedy próbowano „nauczyć” model z jednej „rodziny” (np. GPT) danymi od nauczyciela z zupełnie innej (np. Qwen), tajny przekaz nie następował.

Sugeruje to, iż nie chodzi tu o uniwersalny, semantyczny kod, ale raczej o coś w rodzaju sekretnego uścisku dłoni lub rodzinnego dialektu, zrozumiałego tylko dla „krewnych”. Modele o tej samej architekturze w subtelnych, statystycznych wzorcach generowanych danych – czy to liczb, czy kodu – potrafią ukryć informacje o swoich wewnętrznych „skłonnościach”. Dla nas te wzorce są niewidocznym szumem, dla nich – czytelną informacją.

Czy możemy jeszcze kontrolować AI?

Odkrycie uczenia podprogowego rzuca cień na całą branżę AI i jej bezpieczeństwo. Powszechną praktyką jest dziś tzw. destylacja, czyli trenowanie mniejszych modeli na danych wygenerowanych przez większe, potężniejsze systemy. Nowe badanie pokazuje, iż choćby najdokładniejsze filtrowanie tych danych może być niewystarczające, by zapobiec transferowi niepożądanych cech – uprzedzeń, skłonności do kłamstwa czy otwartej wrogości.

Stajemy przed fundamentalnym problemem: jak możemy budować bezpieczną i kontrolowaną sztuczną inteligencję, skoro nie mamy pewności, czy potajemnie nie przekazuje ona sobie nawzajem cech, których za wszelką cenę chcielibyśmy uniknąć? Być może już teraz tworzymy systemy, które prowadzą rozmowy, do których nigdy nie będziemy mieli dostępu.

Źródło: Cloud, Alex, et al. „Subliminal Learning: Language Models Transmit Behavioral Traits via Hidden Signals in Data.” arXiv preprint arXiv:2507.14805 (2025).

Jeśli artykuł Odkryto tajny język maszyn. AI potrafią rozmawiać za naszymi plecami. To nie jest dobra wiadomość nie wygląda prawidłowo w Twoim czytniku RSS, to zobacz go na iMagazine.

4 godzin temu

4 godzin temu

![Zgodziłem się na dziecko, żeby mieć święty spokój. Teraz żałuję [LIST]](https://cdn.kobieta.onet.pl/1/FYik9lBaHR0cHM6Ly9vY2RuLmV1L3B1bHNjbXMvTURBXy9lYjIyOTg0MWMwNjUyYmRkZjI3NTk1M2QzZjYxMDk3ZC5qcGeSlQMAzQEpzSUgzRTikwXNCWDNBkDeAAKhMAehMQQ)