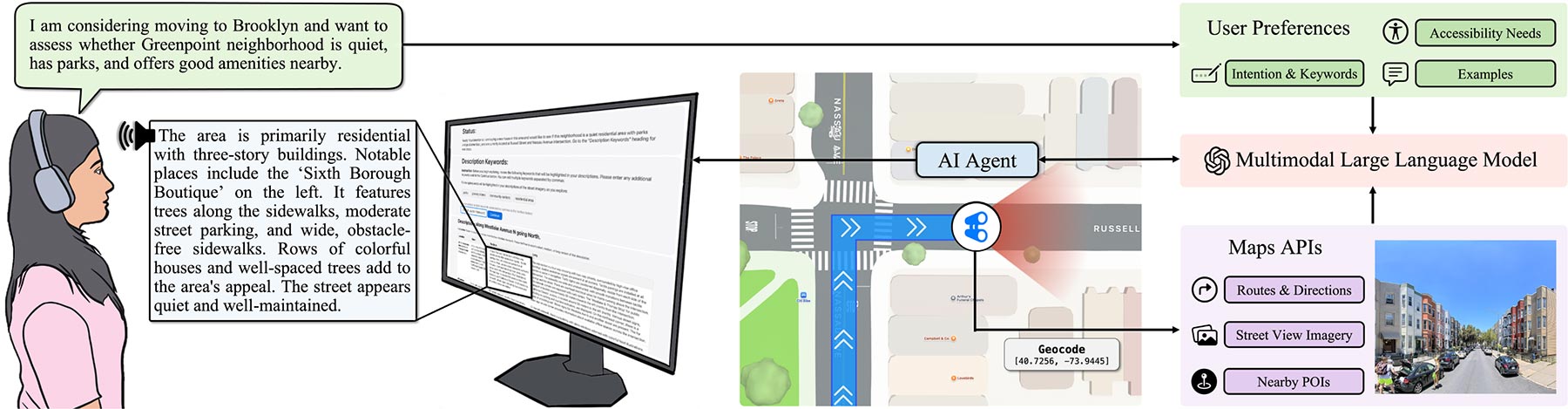

Nowe badanie Apple i Uniwersytetu Columbia prezentuje SceneScout – prototyp systemu AI wspierającego nawigację osób niewidomych i niedowidzących.

Narzędzie wykorzystuje Apple Maps API oraz model językowy GPT-4o, by generować opisy przestrzeni miejskiej widocznej na zdjęciach z poziomu ulicy.

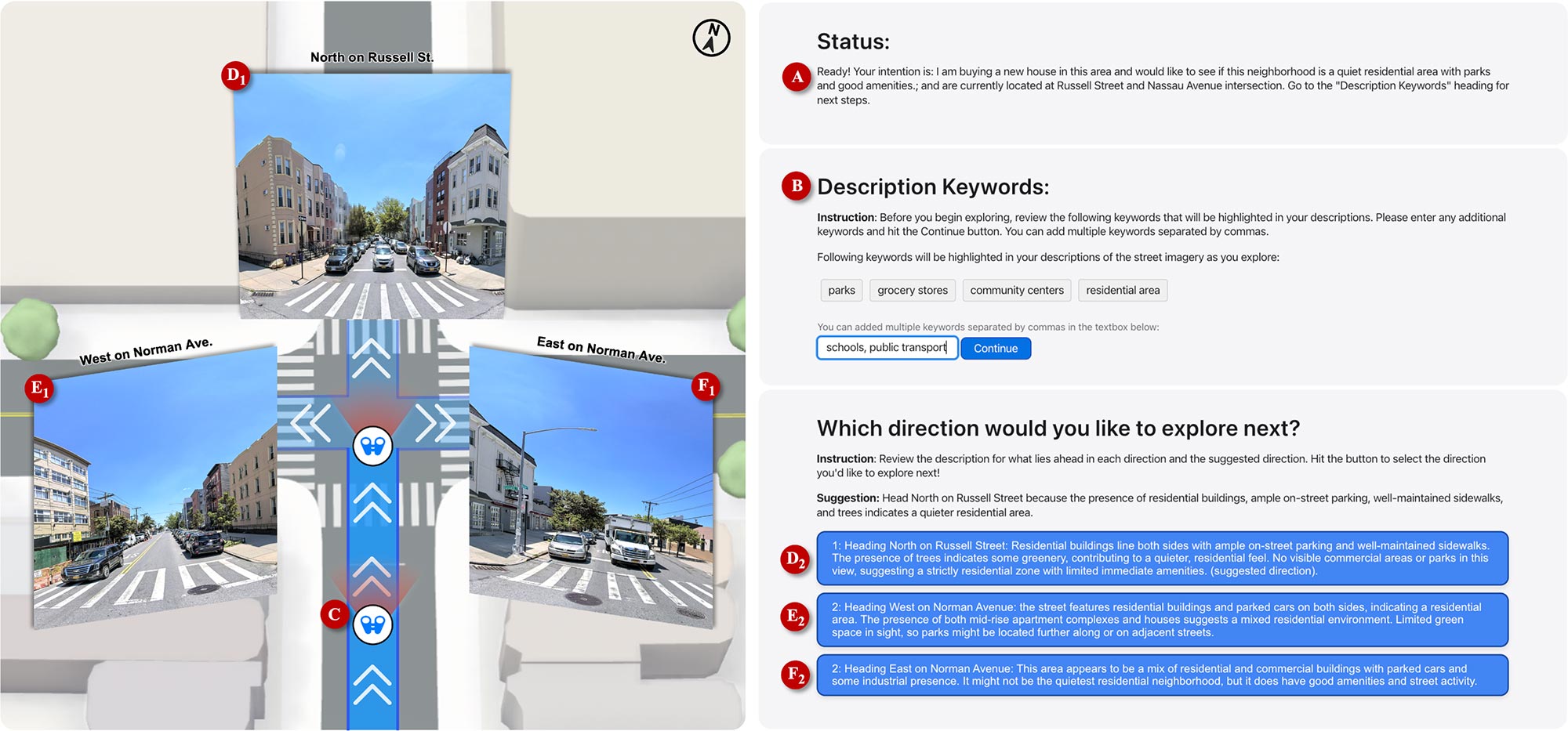

System oferuje dwa tryby:

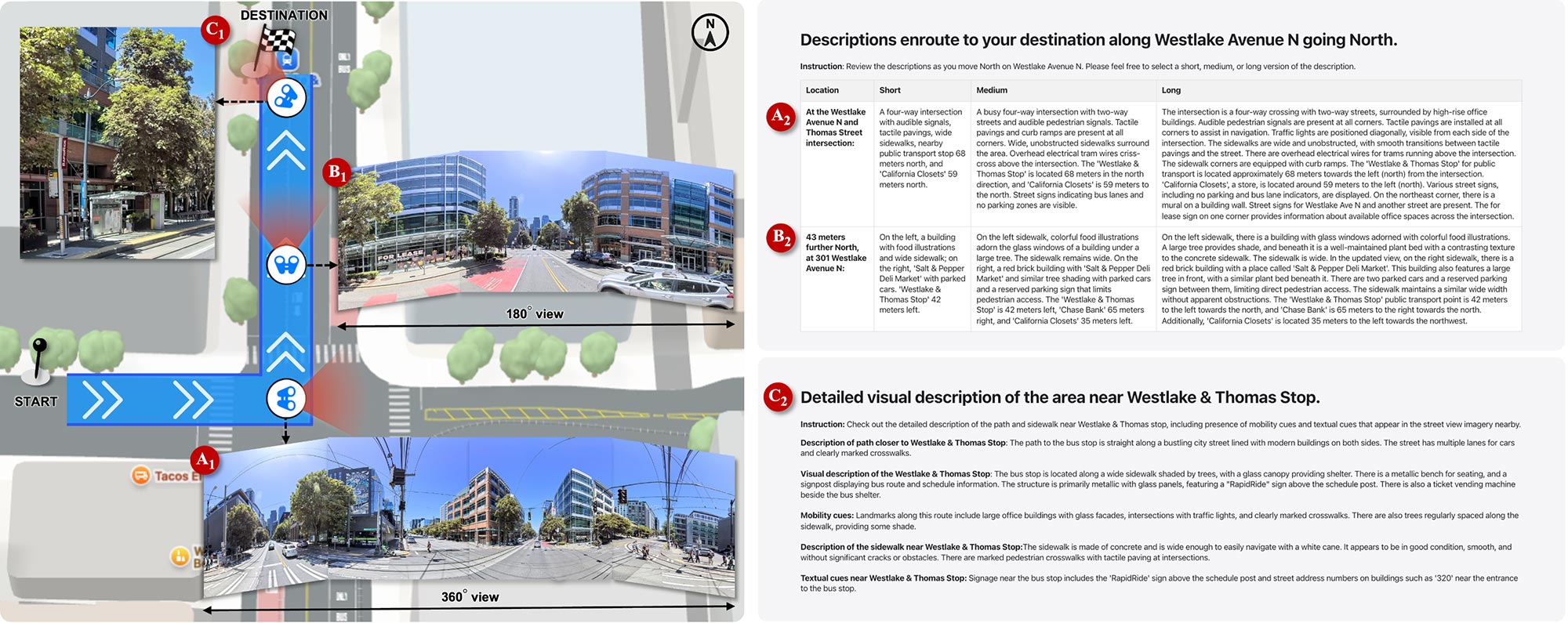

- Route Preview – prezentuje trasę z uwzględnieniem jakości chodników, przejść dla pieszych i punktów orientacyjnych.

- Virtual Exploration – pozwala eksplorować okolice wirtualnie, według własnych preferencji (np. cicha dzielnica blisko parku).

Użytkownicy testowi wysoko ocenili użyteczność rozwiązania, choć pojawiły się problemy z dokładnością opisu, np. mylne informacje o sygnalizacji dźwiękowej lub nieaktualne dane (remonty, pojazdy). Zgłoszono też potrzebę bardziej precyzyjnych i spersonalizowanych informacji, szczególnie podczas ostatnich metrów nawigacji.

W przyszłości użytkownicy chcieliby, aby takie narzędzie działało w czasie rzeczywistym – np. przez słuchawki z przewodnictwem kostnym lub tryb transparentny.

SceneScout nie pozostało produktem rynkowym, ale pokazuje, jak AI i mapy mogą zwiększyć dostępność przestrzeni miejskiej i samodzielność osób z niepełnosprawnością wzroku.

Więcej informacji znajdziecie tutaj i na stronach Apple.

Jeśli artykuł Apple i Columbia University tworzą AI, które pomoże osobom niewidomym poruszać się po ulicach nie wygląda prawidłowo w Twoim czytniku RSS, to zobacz go na iMagazine.

1 miesiąc temu

1 miesiąc temu